Las plataformas de redes sociales controlan la visibilidad del contenido mediante algoritmos complejos. Uno de ellos es el shadowbanning, es decir, la restricción del alcance de un usuario sin que este lo sepa, lo cual plantea serias preocupaciones éticas. Aunque las plataformas sostienen que esta práctica busca limitar el contenido dañino, muchos sostienen que suprime la libertad de expresión y manipula la opinión pública. ¿Cómo afectan estas prácticas a la democracia, la ética y a los creadores independientes? ¿Deberíamos exigirles una dosis de responsabilidad?

Introducción

Los detectores de contenido generado por IA prometen separar lo humano de lo artificial, pero el experimento que sigue muestra que no pocos están, en términos ajedrecísticos, cooked: basta una jugada inesperada, un leve cambio de conector o de tono, para desmontar su pretensión de exactitud. Como en un estudio mal construido, la elegancia desaparece al descubrir que la solución no era única, sino frágil y mal calculada.

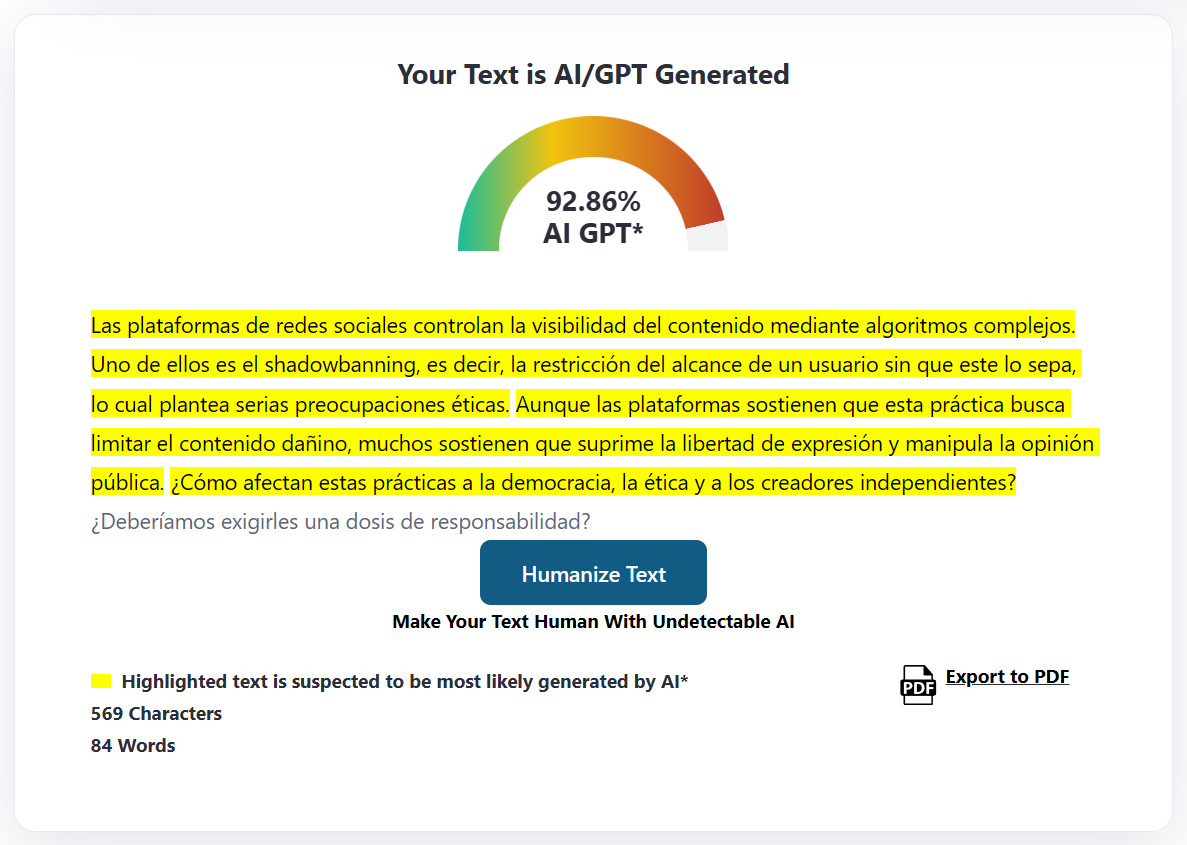

Texto con es decir

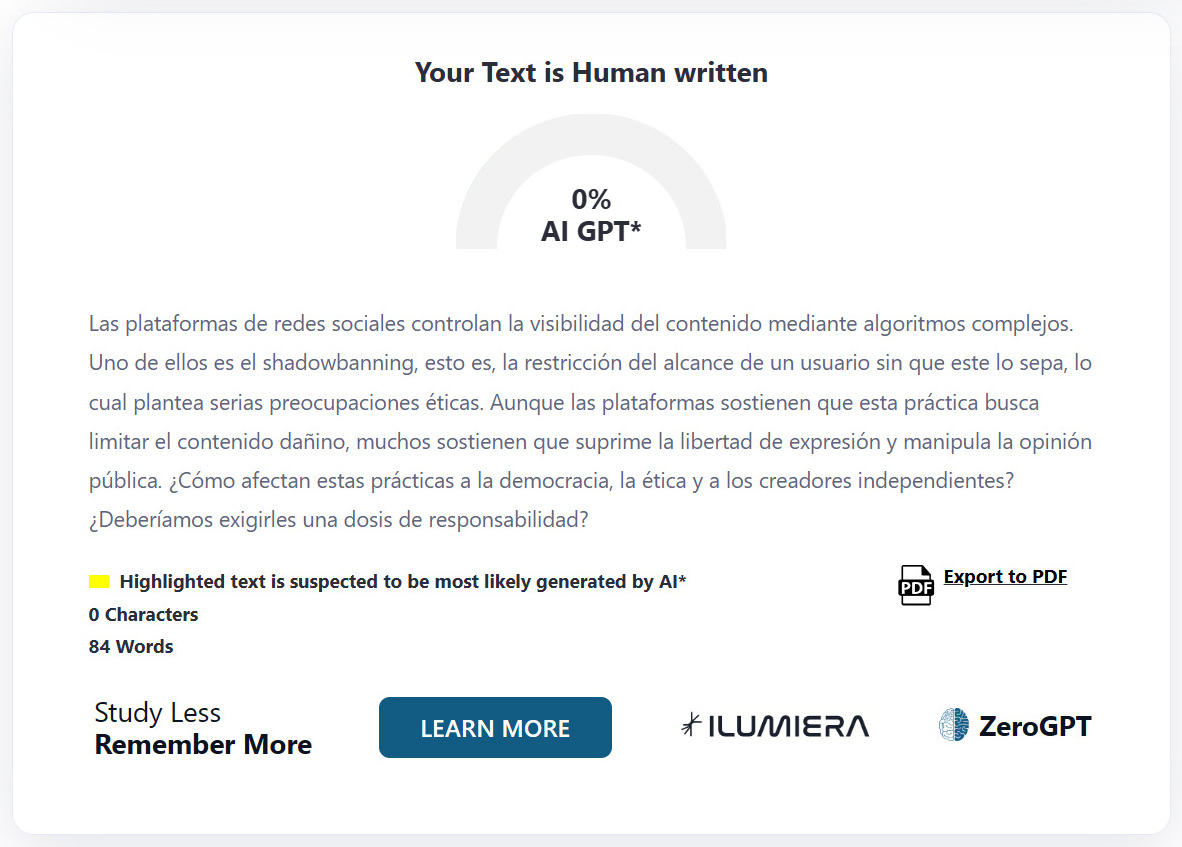

Texto con esto es

Las plataformas de redes sociales controlan la visibilidad del contenido mediante algoritmos complejos. Uno de ellos es el shadowbanning, esto es, la restricción del alcance de un usuario sin que este lo sepa, lo cual plantea serias preocupaciones éticas. Aunque las plataformas sostienen que esta práctica busca limitar el contenido dañino, muchos sostienen que suprime la libertad de expresión y manipula la opinión pública. ¿Cómo afectan estas prácticas a la democracia, la ética y a los creadores independientes? ¿Deberíamos exigirles una dosis de responsabilidad?

Análisis de la Contradicción

El cambio entre “es decir” y “esto es”, dos expresiones prácticamente equivalentes que cumplen la misma función semántica en nuestra lengua, no debería sentenciar la autoría de un texto como artificial.

Esta variación léxica de estilo no afecta en lo más mínimo:

- La estructura sintáctica

- La complejidad conceptual

- La coherencia argumental

- La calidad del contenido

Sin embargo, algunos detectores de IA parecen basarse en algoritmos mal calibrados más que en análisis profundos compatibles con la prosa de nuestro idioma y con el sentido del contenido, lo que acaba produciendo resultados tan absurdos como el que tenemos bajo la lupa.

¿Falsos positivos o negativos?

No se trata de simples desviaciones estadísticas, la explicación habitual, sino de un fallo epistemológico en la raíz algorítmica: estos sistemas confunden variaciones estilísticas inocuas con diferencias sustanciales de autoría, revelando una incomprensión básica de cómo funciona la expresión humana.

Dichos detectores evocan la ingenuidad con que operaban los módulos de análisis de ajedrez a comienzos de los años noventa. Y sí, es una metáfora brillante de evolución intelectual: la fase inmadura de una tecnología que aún no comprendía su propio objeto, igual que muchos de estos detectores que creen cuantificar estilo cuando apenas rastrean frecuencia léxica, sobre la base de entrenamientos todavía en vías de desarrollo que, por el momento, no han llegado a la adolescencia.

Implicaciones y Reflexiones

Esta paradoja desnuda y evidencia problemas estructurales en la tecnología actual de detección de IA:

- Detección basada en marcadores irrelevantes: La tecnología actual de los detectores parece basarse en aspectos cosméticos del texto, descuidando la verdadera sustancia estilística.

- Falsa precisión numérica: La grotesca discrepancia entre un 92,86 % y un 0 %, fruto de un cambio infinitesimal en el texto, desnuda la arbitrariedad del algoritmo y genera más sonrisas que certezas.

- Inconsistencia metodológica: si el sistema es tan sensible y frágil ante cambios mínimos, su validez como herramienta de evaluación queda en entredicho.

Este caso nos recuerda la imperiosa necesidad de cuestionar la fiabilidad de estos detectores antes de permitir que influyan en decisiones humanas de alto impacto, como las evaluaciones académicas, la contratación profesional o la atribución de autoría.

¿Coincidimos o disentimos?

Si este análisis te ha provocado reflexión, escepticismo o simple curiosidad, me encantaría conocer tu perspectiva. Las mejores ideas surgen del diálogo.